SCAM! Transferring humans between images with Semantic Cross Attention Modulation

Introduction

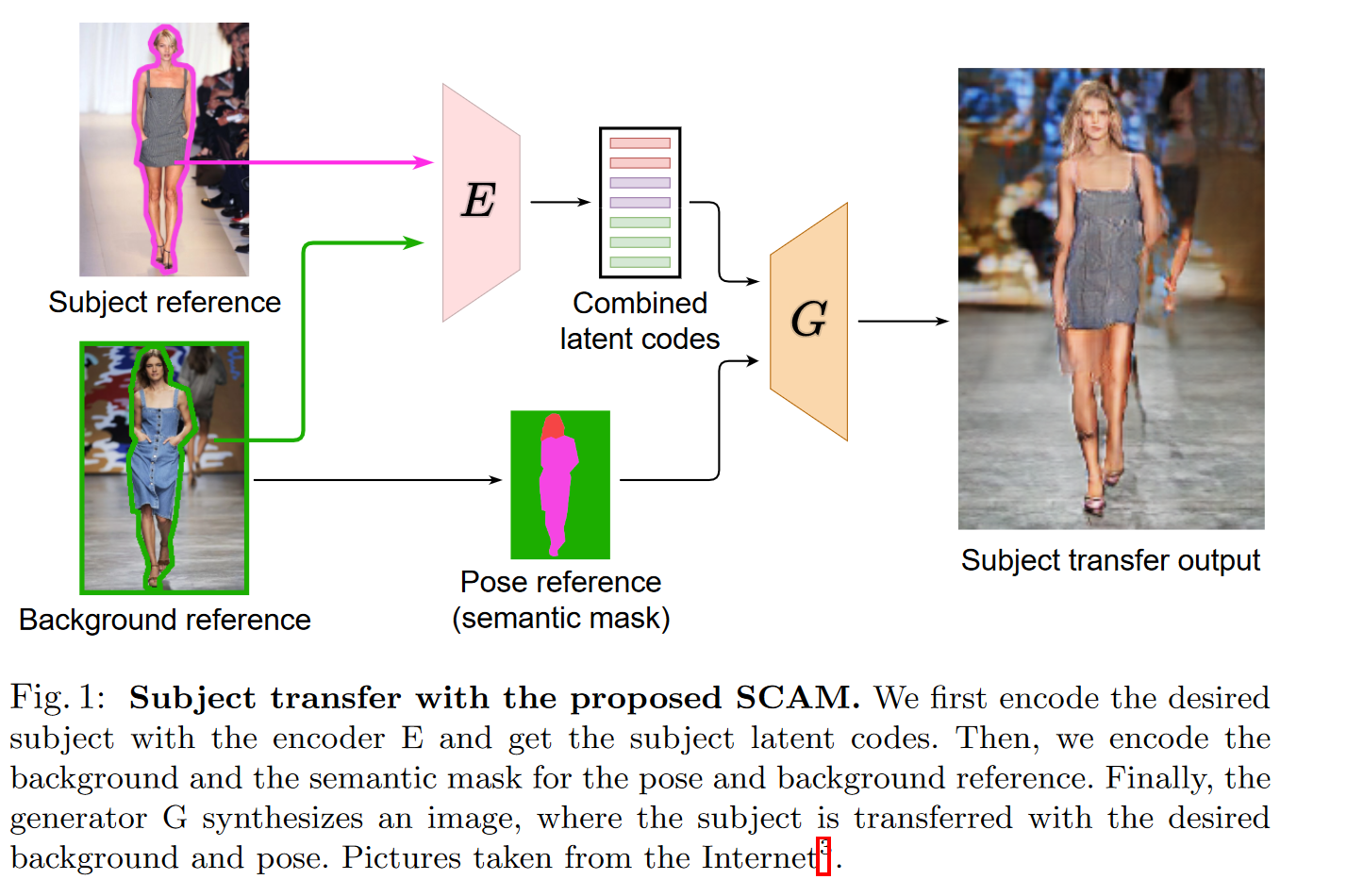

作者首先用编码器E对目标对象进行编码,得到目标潜码。然后,我们对姿态和背景引用的背景和语义掩码进行编码。最后,生成器G合成一个图像,在这个图像中,被摄对象被转换成所需的背景和姿态。

给定一个源和一个目标主体,主体转移的思想是让源主体无缝地替换目标图像中的目标主体。目标图像应该保持相同的背景,相同的主体和对象之间的相互作用,和相同的空间配置,以考虑可能的遮挡。图1说明了这一点。注意,与脸、建筑或景观相比,人体具有高度形态多样性的延展性,因此很难建模。

现如今大多数方法要么专注于姿态迁移,姿态会发生变化,要么专注于风格迁移,姿态保持固定,但主体的风格会发生变化。它们是有限的,因为它们:

- 限制多:它们只在统一的背景下工作,在复杂的背景下就会失败。

- 花费多:他们训练比较困难或者每个人训练一个模型。

主体转移改变了主体的姿势和风格/身份。因此,一个成功的系统在姿势和风格转移上都是解耦的,并同时执行这两个任务。

语义编辑是一个相关的任务,包括通过分割掩码控制生成网络的输出。事实上,通过使用目标主题的掩码和源主题的样式,可以使用语义编辑来执行主题迁移。然而,现代方法无法处理复杂的布局和丰富的结构(如完整的身体)在自然背景。

例如SPADE无法独立控制每个区域风格,而SEAN无法处理复杂、详细的场景,比如多个背景对象。

作者提出了一种语义解释模型 Semantic Cross Attention Modulation system(SCAM),可以解释上述所有与主题转移相关的挑战。

SCAM 通过每个语义区域具有多个潜在对象来捕获语义区域内的精细图像细节。这可以在语义标签内捕获无监督的语义信息,从而可以更好地处理粗略的语义标签,例如背景。SCAM可以生成更复杂的背景,在主题迁移和语义重建任务上都优于SEAN。

贡献

- 提出了语义交叉注意(SCA),它在一组潜在的(每个都链接到一个语义区域)和一个图像特征图之间执行注意。 SCA 限制了注意力,例如潜在的只关注图像特征图上与相关语义标签相对应的区域。

- 引入了 SAT 操作和编码器(Semantic Attention Transformer),它依赖于交叉注意力来决定在图像中收集哪些信息以及哪些潜在信息,从而允许对更丰富的信息进行编码。

- 提出SCAM-Generator(以 SCAM 命名),它使用 SCAM-Operation 调制特征图,允许每个像素关注语义上有意义的潜在。

请注意,整个架构仅使用重建设置进行训练,并且在测试时执行主题迁移。

Related work

使用GAN及逆行图像到图像生成

无法访问主体已转移的地面实况图像,因为它需要主体和参考具有完全相同的姿势和遮挡。 作者通过在重建代理任务上进行培训并在测试时执行主题转移来规避此问题。

语义图像生成

即使 Pix2Pix 设法用分割掩码控制输出图像,它也会遭受语义信息的清洗。 SPADE 建议通过引入分层语义调节来解决这个问题。 CLADE 提出了一个更高效的 SPADE 版本来降低运行时的复杂性。然而,这些方法可以很好地从语义信息生成图像,但它们并不关注我们想要重新生成给定图像然后能够对其进行编辑的情况。 为此,必须对图像的样式进行仔细编码,并从 SPADE 及其变体中使用的单一样式向量中移除。SEAN 提议通过对编码器 CNN 特征执行平均池化来为每个语义标签引入一个样式向量。 GroupDNet 提出通过使用分组卷积分别编码每个语义区域来解决这个问题。 INADE 建议使用实例条件卷积来为每个实例提取单个样式代码。 尽管这可以更好地控制输出和更丰富的表示,但它仍然存在两个问题:(1) 在处理具有不同对象的粗糙标签时受到限制,(2) 它为每个语义区域创建一个向量。 在我们的方法 SCAM 中,我们通过引入 SAT-Encoder 来解决这个问题,它可以从图像中提取丰富的表示,并且能够为每个语义区域输出多个不同的潜在。 反过来,SEAN 生成器通过语义掩码和提取的样式来调制输出。 然而,这会用相同的样式向量调制语义区域的每个像素。 相反,我们的 SCAM 生成器使用注意力来利用不同的标记进行交互,从而导致每个像素进行不同的调制,从而在语义区域中出现无监督语义结构。 其他方法建议使用扩散过程方法来执行此编辑过程。 然而,这些扩散方法的采样成本非常高。

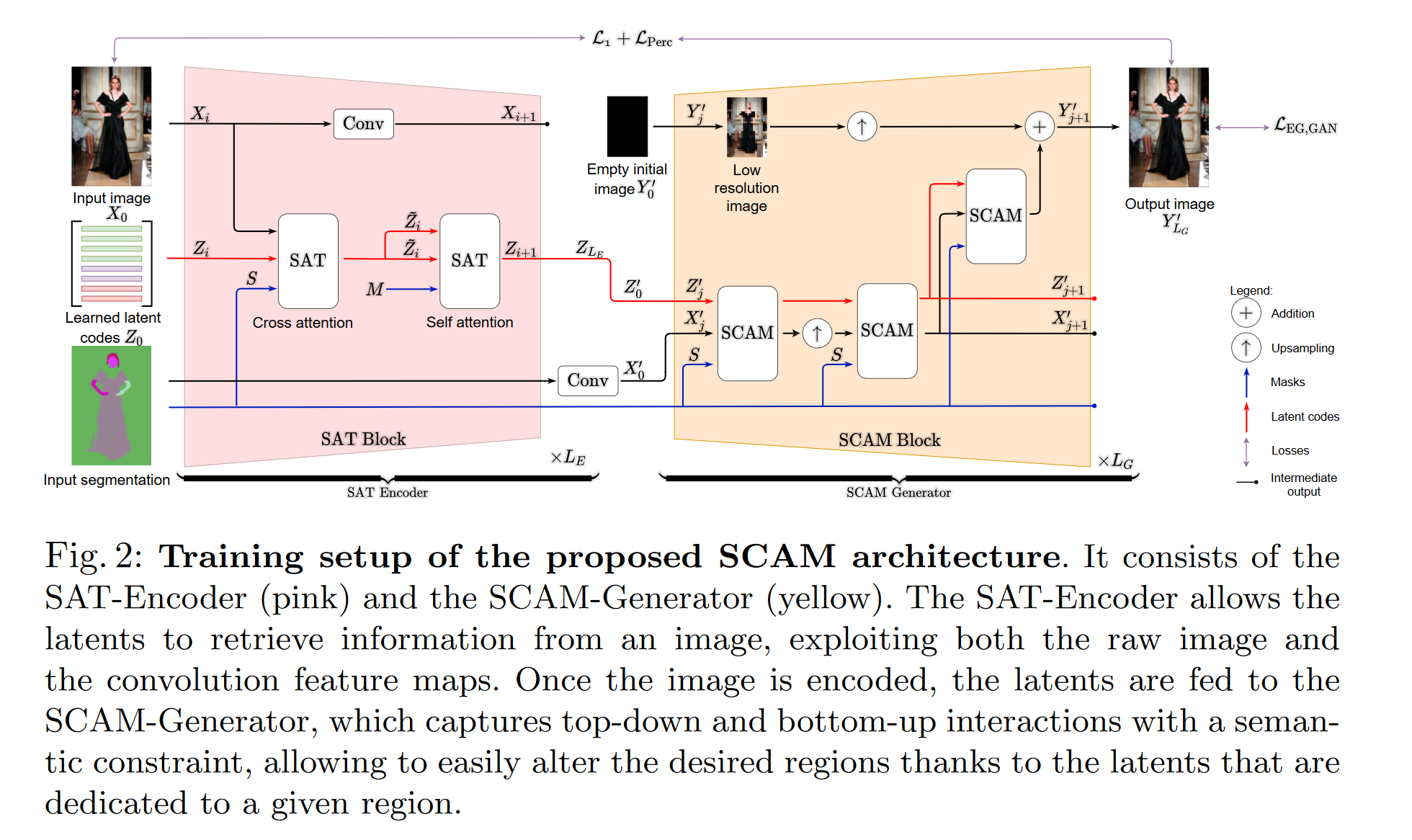

拟议的 SCAM 架构的训练设置。 它由 SAT-Encoder(粉色)和 SCAM-Generator(黄色)组成。 SAT-Encoder 允许 latents 从图像中检索信息,同时利用原始图像和卷积特征图。 一旦图像被编码,隐码被馈送到 SCAM-Generator,它捕获具有语义约束的自上而下和自下而上的交互,由于专用于给定区域的潜伏,允许轻松改变所需区域。

计算机视觉中的注意力。

尽管它们取得了显着的成功 ,但 transformer 仍存在二次复杂度问题,这使得它难以使用。 为了解决这个问题,大多数视觉方法将图像细分为小块,导致信息丢失。 相反,最近的 Perceiver 通过用交叉注意力代替自我注意力来解决这个复杂性问题。 图像像素由一组明显更小的学习标记组成。

GANS的注意力

它在过去几年中取得了很大进步。 GANsformer 利用交叉注意力来利用样式向量和特征映射之间的多个样式代码。 这些架构将注意力用于无条件生成; 但是,他们并不关注主题迁移。 相反,我们提出的 SCA 通过将潜在分配给语义区域来改进 GANsformer 对语义约束生成的双重关注。

姿态转移

使用关键点进行姿势转移通常会导致身体的粗略表示。 为了解决这个问题,一些方法使用语义掩码 。 然而,这些只关注姿势转移,不会改变背景。 相反,我们的目标是主题转移,其中保留背景至关重要。 大多数方法仅限于简单的背景。 将 GAN 过拟合到视频并重新生成背景; 因此,它不能用于动态场景。 通过调整生成器的权重来解决这个问题,但这将主题与背景联系在一起,不允许主题转移。 在这里,我们专注于改变姿势和背景的主题转移。

3. Method

我们的目标是执行以主题转移为重点的语义编辑。 我们提出了 SCAM 方法(Semantic Cross Attention Modulation,图 2)。 它依赖于 SCA(语义交叉注意力),即一种根据分割掩码来掩蔽注意力的新机制,从而编码语义上有意义的潜在变量(第 3.1 节)。

SCAM 包括:

(a) SAT-Encoder(语义注意转换器),它依靠交叉注意来决定在图像中收集哪些信息以及哪些信息是潜在的(第 3.2 节);

(b) SCAM-Generator(语义交叉注意调制)以无监督的方式捕获丰富的语义信息(第 3.3 节)。

方法

令 $x\in \R^{n\times C}$ 为特征图,其中 n 为像素数,C 为通道数。 令 $Z\in \R^{m\times d}$ 为 m 个维度为 d 的潜在变量组成一组,s 为语义标签的数量。 每个语义标签都归因于 k 个潜在变量,使得 m = k × s。 每个语义标签掩膜在 $S\in \{0;1 \}^{n\times m}$ 。 $\sigma(.)$ 是 softmax 操作。

研究动机

由于图像的许多区域具有视觉上不同的内容(例如,背景),我们建议将这些不同的信息编码为几个互补的潜在信息。 受 Gansformers 发现的启发,我们使用注意力来引入对潜在图像的哪一部分可以从中获取信息的约束,以及进入同一区域的潜在图像之间的竞争机制,以便对它们进行专门化。 相反,使用双重注意力,我们通过限制特征图可以关注的隐码来引入相同的策略,并在可以关注相同隐码的语义区域的部分之间引入竞争。

3.1 语义交叉注意力 (SCA)

定义

SCA 的目标有两个,具体取决于什么是查询和什么是键。 它要么允许从一组语义受限的潜在变量中提供特征图信息,要么分别允许一组潜在变量在特征图的语义受限区域中检索信息。 它被定义为:

$$ SCA(I_1,I_2,I_3)=\sigma(\frac{QK^T\odotI_3+\tau(1-I_3)}{\sqrt{d_{in}}})V, \tag{1} $$

$I_1,I_2,I_3$是输入,其中$I_1$参与$I_2$,并且$I_3$强制来自 $I_1$ 的标记仅参加来自 $I_2^{[1]}$ 的特定标记的掩码,$Q=W_QI_1,K=W_KI_2 和 V=W_VI_2$查询,键和值,和$d_{in}$内部注意力维度。

我们使用三种类型的 SCA。

(a) 具有像素 X 参与潜在 Z 的 SCA:SCA(X, Z, S),其中 $W_Q\in \R^{n\times d_{in}}和 w_K,W_V\in \R^{m \times d_{in}}$。 这个想法是强制来自语义区域的像素参加与相同标签相关联的隐变量。

(b) 具有潜在 Z 参与像素 X 的 SCA:SCA(Z, X, S),其中 $W_Q\in \R^{m\times d_{in}},w_K,W_V\in \R^{n \times d_{in}}$。 这个想法是在语义上掩盖注意力值,以强制隐变量参与语义对应的像素。

(c) 具有潜在 Z 的 SCA:SCA(Z, Z, M),其中 $W_Q,W_K,W_V\in\R^{n\timesd_{in}}$。 我们将这个隐变量表示为$M\in\N^{m\times m}$,如果隐变量 i 的语义标签与隐变量 j 的语义标签相同,则 $M_{latents}(i,j)=1$否则$=0$。 这个想法是让隐变量只参与共享相同语义标签的隐变量。

3.2 SAT-Encoder SAT编码器

SAT-Encoder 依赖于交叉注意力。 它由 LE 连续层 SAT-Blocks 组成,其中第 i+1 个的输入是第 i 个的输出(图 2(左))。给定一组学习查询(参数?) $Z_0$(即,使用反向传播通过梯度下降更新的参数),它输出对输入图像进行编码的隐码$Z_{L_E}$ 。这允许为每个语义区域创建多个隐变量,从而为图像的每个语义区域的不同部分生成专门的隐变量。 编码器也足够灵活,可以轻松地为每个语义区域分配不同数量的隐变量,从而优化赋予每个语义区域的表示能力。 在每一层,隐码从不同比例的图像特征图中检索信息。

SAT-Block 由三个部分组成:两个 SAT-Operations 和一个 strided convolution。 SAT-Operations 是类似 transformer 的操作,用我们提出的 SCA 取代了自注意力。

它们被定义为:

$$ SAT(I_1,I_2,S)=LN(f(LN(SCA(I_1,I_2,S)+I_1))+I_1),\tag{2} $$

LN 是层范数,f 是一个简单的 2 层前馈网络。

第一个 SAT-Operation,SAT(X, Z, S),让潜网络从图像特征图中检索信息(3.1 中的案例 (b))。

第二个 SAT-Operation,SAT(Z, Z, M),在自注意设置中使用 SCA 精炼潜伏,其中潜伏自我关注,保持语义限制(来自 3.1 的案例 (c))。

跨步卷积对前一层图像特征图进行编码,减少其空间维度。

3.3 SCAM-Generator SCAM-生成器

定义和架构

SCAM-Generator 将隐码 $Z’_0(= Z_{L_E} encoder’s output)$和分割隐码 S 作为输入,并输出生成的图像 $Y'_{L_G}$。它由$L_G \;SCAM-Blocks$ 组成(图 2(右))。 生成器的输入隐变量由编码器的输出给出,而生成器中每个块的输入隐变量是前一个块的输出隐变量。类似地,每个块的输入特征图是每个分辨率的特征图输出,而对于第一个特征,我们使用之后的卷积层对分割进行编码。

SCAM-Block 具有类似于 StyleGAN2的渐进式增长架构,由 3 个 SCAM-Operations 组成(见图 2(右))。2 SCAM-Operations 处理生成器特征图,在两者之间进行放大操作,而并行 SCAM-operation 从特征图中检索信息并在 RGB 空间中生成图像。 实施细节和参考代码在补充中。

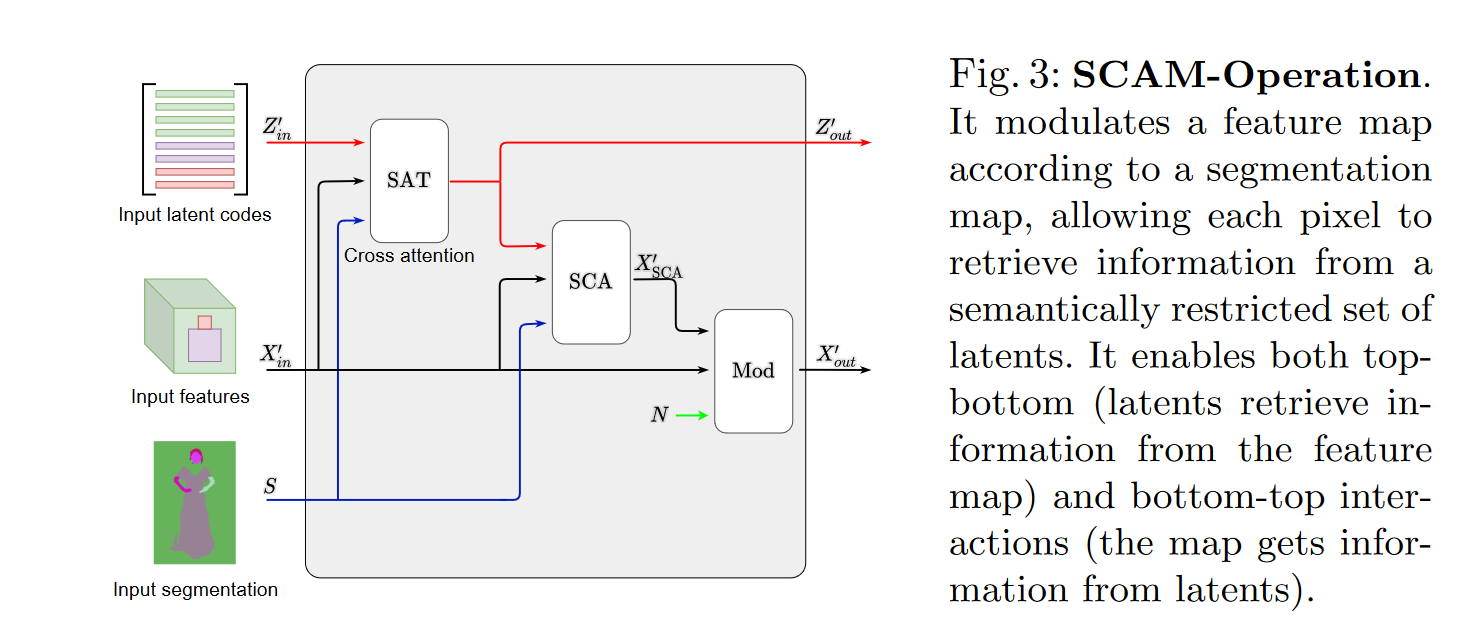

图 3:SCAM-Operation。 它根据分割图调制特征图,允许每个像素从语义受限的隐变量集合中检索信息。 它同时支持 topbottom(隐变量从特征图中检索信息)和 bottom-top 交互(地图从隐变量中获取信息)。

SCAM-Operation.

它旨在在相同语义标签的像素/特征和隐变量之间交换信息,如图 3 所示。

每个 SCAMOperation 都有输入:

(1) 输入隐变量 $Z'_{in}$的集合

(2) 输入特征映射 $X'_{in}$ ,

(3) 分割掩膜 $S$

它的输出是:

(1) 输出隐变量 $Z'_{out}$

(2) 输出特征图 $X'_{out}$

SCAM-Operation 由三部分组成:(a) the latent SAT(b) the feature SCA(c) the Modulation operation

(a) The latent SAT.

它使用 SAT 操作根据当前特征图更新当前隐变量 $Z'_{in}$: $Z'_{out:=SAT(Z'_{in},X'_{in},S)}$。由于 SAT 内部的 SCA 操作,这允许在执行隐变量语义约束的同时进行隐变量细化。

(b) The feature SCA

执行隐变量的图像注意:它使用 SCA 将潜在信息合并到像素/特征。 给定 $X'_{in}$,SAT-Operation Z'out 的输出隐变量和掩膜 $S$,它输出 $X'_{SCA}$:

$$ X'_{SCA}=SCA(X'_{in},Z'_{out},S).\tag{3} $$

(c) The Modulation operation

将图的$X'_{in}$ 和来自 SCA 的 $X'_{SCA}$ 作为输入,并输出通过卷积层 $g(.)$ 产生最终输出图像特征 $X'_{out}$的特征。它被定义为:

$$ X'_{out}=g(\gamma(X'_{SCA})\odot IN(X'_{in})+\mu (X'_{SCA})+N).\tag{4} $$

它由 $\gamma(.)$ 和 $\mu(.) $运算符组成,用于确定调制操作(the modulation operation)的比例和偏置因子。我们使用实例归一化(IN)来执行特征图归一化。在之后,我们还添加了噪声 $N\in \R^{n\times C}$,其中 $N ∼ N (0, \sigma^2I_{n\times C}) $和 $\sigma$学习参数。 这鼓励modulation考虑随机变化。

讨论

SCAM-Operation 输出调制后的特征图和更新后的隐特征。 因此,来自先前地图的信息被传播到隐变量和特征地图。 这带来了几个好处:首先,它保留了语义约束; 其次,它通过关注多个隐变量在语义掩膜内提供更精细的细化; 第三,它允许每个像素选择用于调制的隐变量。

3.4 Training losses

我们用 GAN 和重建损失训练 SCAM。我们用 D 表示鉴别器,G 表示生成器,E 表示编码器。

对于鉴别器,我们遵循并使用 PatchGAN,因为它鉴别给定图像的补丁而不是全局图像。

对于 GAN 损失,我们使用 Hinge GAN 损失:$L_{EG,GAN},L_{D,GAN}$。

对于重建损失,我们使用感知损失 LPerc 和输入与重建输入之间的$L_1$。

最终损失为 $L_{EG}=L_{EG,GAN}+\lambda_{perc}L_{Perc}+\lambda_1L_1$和$L_D=L_{D,GAN}$,具有 $\lambda_{perc} $和 $\lambda_1$ 超参数。我们在实验中使用$ \lambda_{perc}=\lambda_1=10$。

3.5 Subject transfer 主题迁移

一旦对 SCAM 进行了重建训练,我们就会在测试时执行主题迁移。 给定两个图像 $X_A$、$X_B$ 及其各自的分割掩膜$(S_A,S_B)$,我们使用 SAT 编码器将它们的隐变量代码检索为 $Z_A$ 和 $Z_B$。为了将主题从 $X_B$ 转移到 $X_A $的上下文,我们创建了 $Z_{mix}$,其中与背景相关的样式代码来自 $Z_A$,其余代码来自 $Z_B$。 然后,我们检索 $Y'_{ mix}=G(Z_{mix}, S_B)$。 参见图 1。

### 4. Experiments

We train all models for 50k steps, with batch size of 32 on 4 Nvidia V100 GPUs. We set k=8 latents per label of dim d=256. We generate images of resolution 256px.

4.1 Datasets and metrics 数据集和指标

iDesigner

包含来自设计师时装秀的图像,包括 50 位不同的设计师以及 50k 训练和 10k 测试样本。 我们用 [24] 分割人体部位,然后合并标签以结束:面部、身体和背景标签。

- Li, P., Xu, Y., Wei, Y., Yang, Y.: Self-correction for human parsing. In: IEEE TPAMI (2020)

CelebAMask-HQ

包含来自 CelebA-HQ 的名人面孔,带有 28k 训练和 2k 测试图像,标记有 19 个高质量语义标签。

ADE20K

包含具有 20k 火车和 2k 测试图像的不同场景图像。 这些图像标有 150 个高质量的语义标签。

Metrics.

我们使用 PSNR、重建 FID (R-FID) 和交换 FID (S-FID)。 R-FID 被计算为训练集和重建测试集之间的 FID,而 S-FID 是在测试集和在测试集上计算的一组主题转移图像之间。 我们介绍了在重新识别网络 的潜在空间中计算的 REIDAcc 和 REIDSim。 REIDSim 计算主题图像和主题传输图像之间的平均余弦相似度。 REIDAcc 占转移主体的余弦相似度与主体的余弦相似度高于与背景的图像的比例。

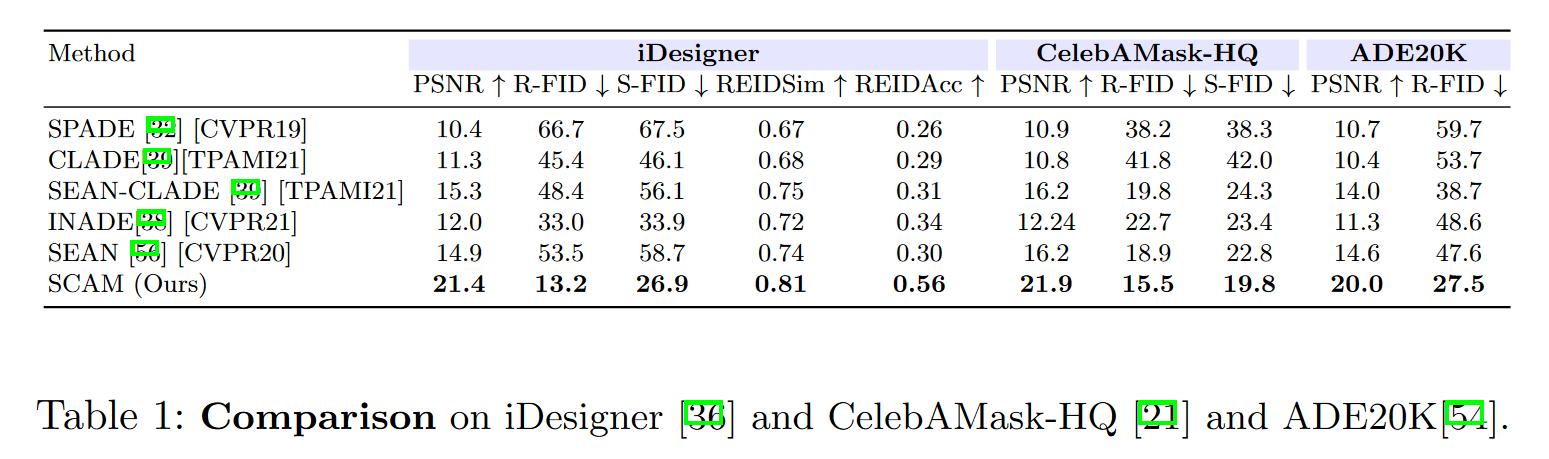

4.2 Comparison to the state of the art 进行比较

首先将提出的 SCAM 与 INADE、SEAN、CLADE、SEAN-CLADE 和 SPADE进行比较。

总体而言,SCAM 在所有指标上都优于竞争方法。

S-FID 的差异也很明显,INADE 达到 33.9 而 SCAM 达到 26.9,表明SCAM在具有粗语义标签的数据集上比其他方法执行更好的主题转移。

4.3 Ablations

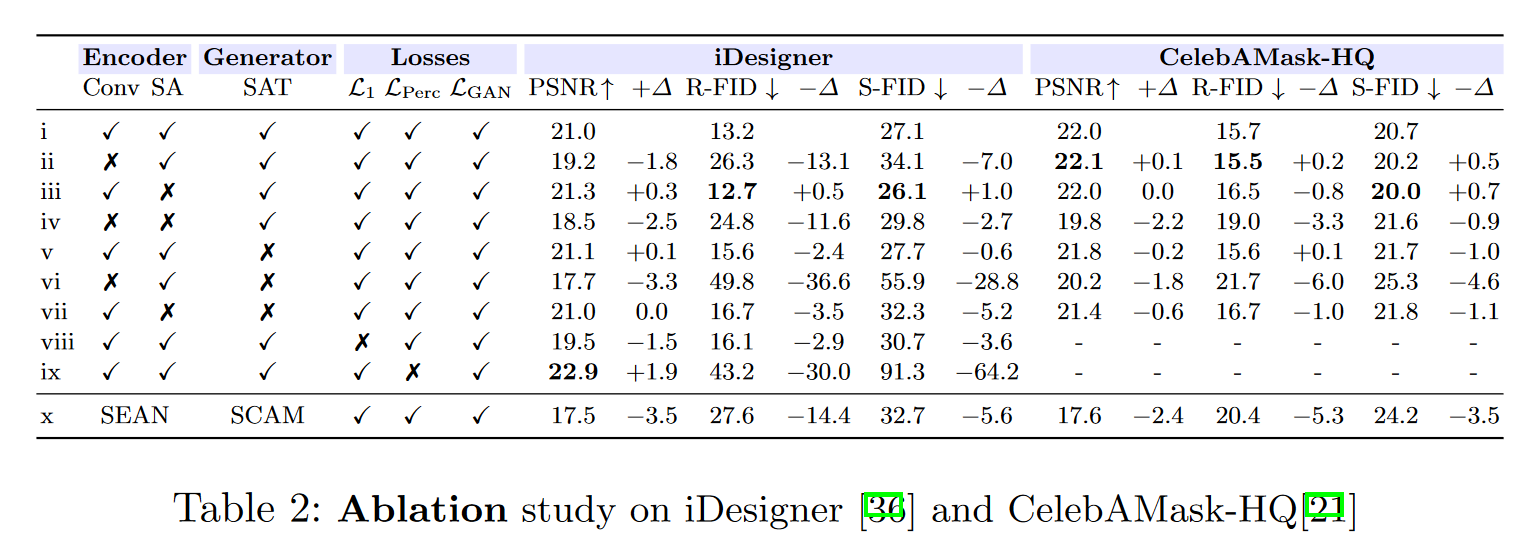

在这里,我们进行了几次消融以验证 SCAM 所有组件的有效性。 我们用——不收敛的实验表示。

SAT 编码器和 SCAM 生成器的消融。

我们通过使用基线版本修改 SAT 编码器或 SCAM 生成器来检查我们的编码器和生成器的有效性,并在表 2 中报告 iDesigner 上的结果。第一行 (i) 对应于我们的 SCAM。 我们对 SAT 编码器的一些变体进行了基准测试:Conv 表示我们是否在 SAT 中使用卷积。 SA 表示我们是否使用自注意力 SAT 块。 结果表明,SAT 编码器中的整体卷积提供了很大的编码优势。 对于复杂的 iDesigner 数据集尤其如此。 事实上,(i) 在 iDesigner 上的表现优于 (ii, iv, vi),例如 (ii) 的 -13.1 R-FID 和 -7.0 S-FID,这验证了我们在编码器中使用多种分辨率。

我们还通过删除 SCAM 块中的 SAT 块来检查生成器的变体。在 SCAM 中获得 SAT 会带来更好的结果; 例如 RFID 中的 -2.4,以及 iDesigner 上 (v) 的 S-FID 中的 -0.6。 在(vi 和 vii)中可以观察到类似的结果。

在 (x) 中,我们使用与 SEAN 中相同的编码器和 SCAM 生成器。 为了设法让每个语义隐变量具有多个隐变量,我们将 SEAN 编码分成 8 个较小的隐变量,用于每个语义隐变量。 我们在这里观察到我们的 SAT 编码器在从图像中提取信息方面优于 SEAN 编码器。 事实上,我们的编码器比 SEAN 编码器获得更好的 R-FID 和 S-FID (-14,4/-5.6)。

损失消融

表 2 (i,viii,ix) 消除了 SCAM 中使用的三个 L1、LPerc、LGAN 损失。 全组合(i)达到最佳效果。 有趣的是,移除 LPerc (ix) 会导致最佳 PSNR 点 (22.9db),同时具有最差的 R-FID 和 S-FID(分别为 43.2、91.3)。 这是意料之中的,因为移除感知损失使得生成器仅依赖于 L1 损失,并且可能以牺牲真实性为代价人为地增加 PSNR。

每个语义标签的隐变量数量 k。

我们研究了每个语义标签的隐变量数量 k 对模型性能的影响。 我们在 iDesigner 上测试了 $k \in [4, 8, 16, 32]$。 我们发现 R-FID 随着 S-FID 减少的隐变量数量的增加而增加。 事实上,对于 k = 4,我们有 15.9 的 R-FID 和 27.3 的 S-FID。 对于 k = 32,我们有 9.7 的 R-FID 和 30.3 的 S-FID。 我们在实验中选择 k = 8,因为它提供了 S-FID 和 R-FID 之间的最佳权衡。 我们还优先考虑较小的 k,因为我们模型的时间复杂度为 O(k)。

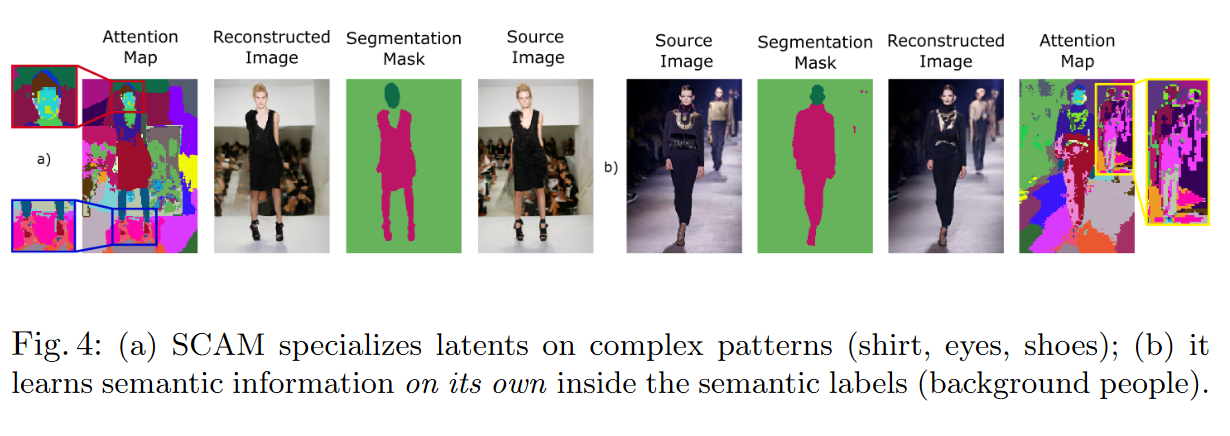

图 4:(a) SCAM 专注于复杂图案(衬衫、眼睛、鞋子)的隐变量; (b) 它在语义标签(背景人物)中自行学习语义信息。

注意矩阵的可视化。

为了研究 SCAM 如何处理每个区域的多个隐变量,我们在图 4 中可视化了最后一个 SCAM 层注意矩阵。 我们根据具有最高注意力值的相应潜在变量为每个像素着色。 总的来说,我们观察到对于每个语义区域,隐变量参与不同的子区域,在没有监督的情况下捕获语义信息。 第一个示例 (a) 表明,即使没有专门的分割标签,SCAM 也专门使用一些隐变量特征来重建复杂的面部图案(眼睛、嘴巴和头发),并为不同的身体部位(衣服和鞋子)重建其他特征。 第二行显示了一个有趣的案例:SCAM 能够为背景中的人分配不同的潜在变量,即使他们没有被标记为这样。

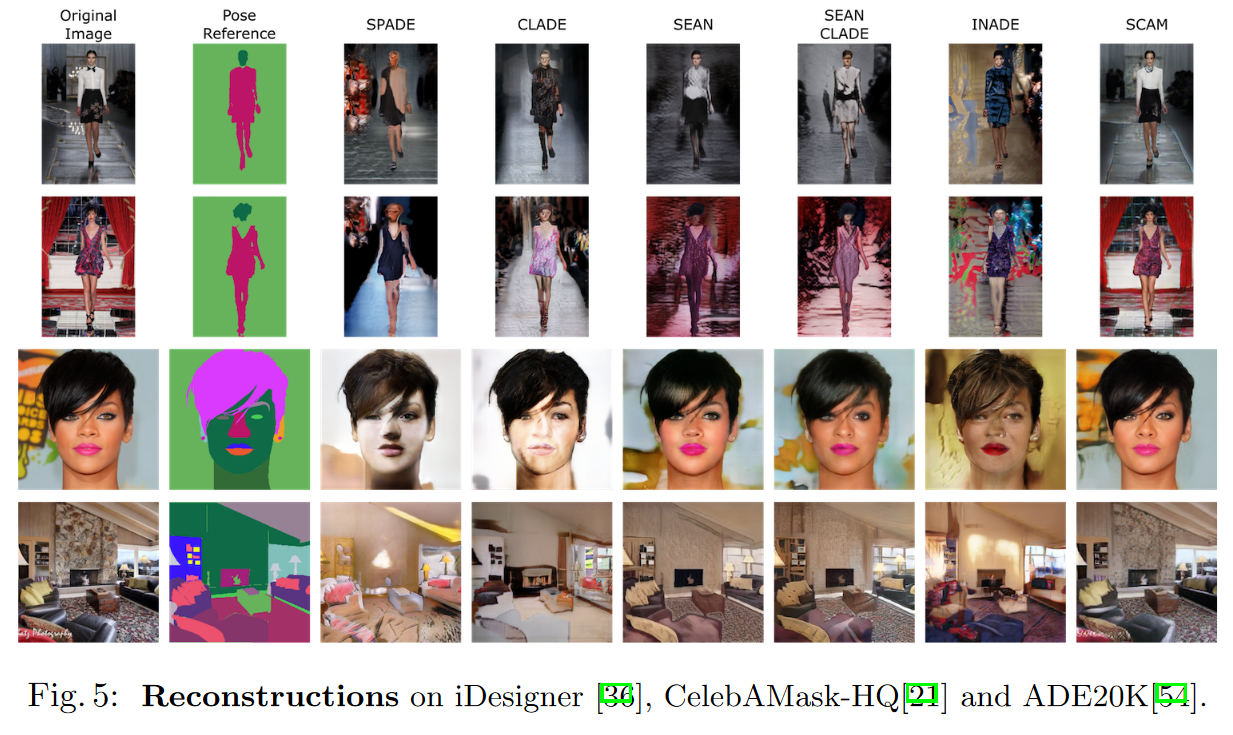

4.4 Qualitative results on reconstruction 重建定性结果

总体而言,我们观察到 SCAM 的重建质量优于竞争方法。 图 5 显示了输入图像、它们的掩码(前两列)以及 SPADE 、CLADE 、SEAN 、SEAN-CLADE 、INADE 和 SCAM 的重建(最后六列) ). 前两行是来自 iDesigner 的示例,第三行来自 CelebAMask-HQ,最后一行来自 ADE20K。

iDesigner 上的主题重建。

SCAM 比 SEAN 重建了更多的结构,无论是在背景还是在人类方面。 INADE、CLADE 和 SPADE 倾向于生成与原始图像风格不匹配的图像。 对于背景,我们观察到第二排的窗帘和窗框由 SCAM 重建得很好,这与包含颜色但没有其他框架提示的 SEAN 形成鲜明对比。 这突出了 SCAM-Generator 丰富的生成能力,它设法生成竞争方法失败的复杂背景。 对于主题,与其他方法相比,SCAM 可以实现更精细的重建。 例如,在第一行中,SCAM 重建连贯的衣服,而 SEAN 生成衣服的模糊版本。

在 CelebAMask-HQ 上重建。

总的来说,SCAM 产生的结果比竞争方法更清晰、更真实。 例如,在第三行中,SEAN 未能通过生成平均纹理完全重建背景。 我们的方法在这方面做得更好,为徽标找出更好的定位并捕获更好的颜色和形状。 在这个问题上,我们还观察到 SEAN 未能捕捉到眼睛颜色等小细节。

在 ADE20K 上重建

SCAM 具有比竞争方法更可靠的重建。 在第四行,我们观察到 SCAM 是唯一能够在烟囱壁上重建某些纹理的方法。还观察到总体而言,SCAM 在重建对象中具有更多细节,而 SEAN 等方法往往具有更平均的纹理。

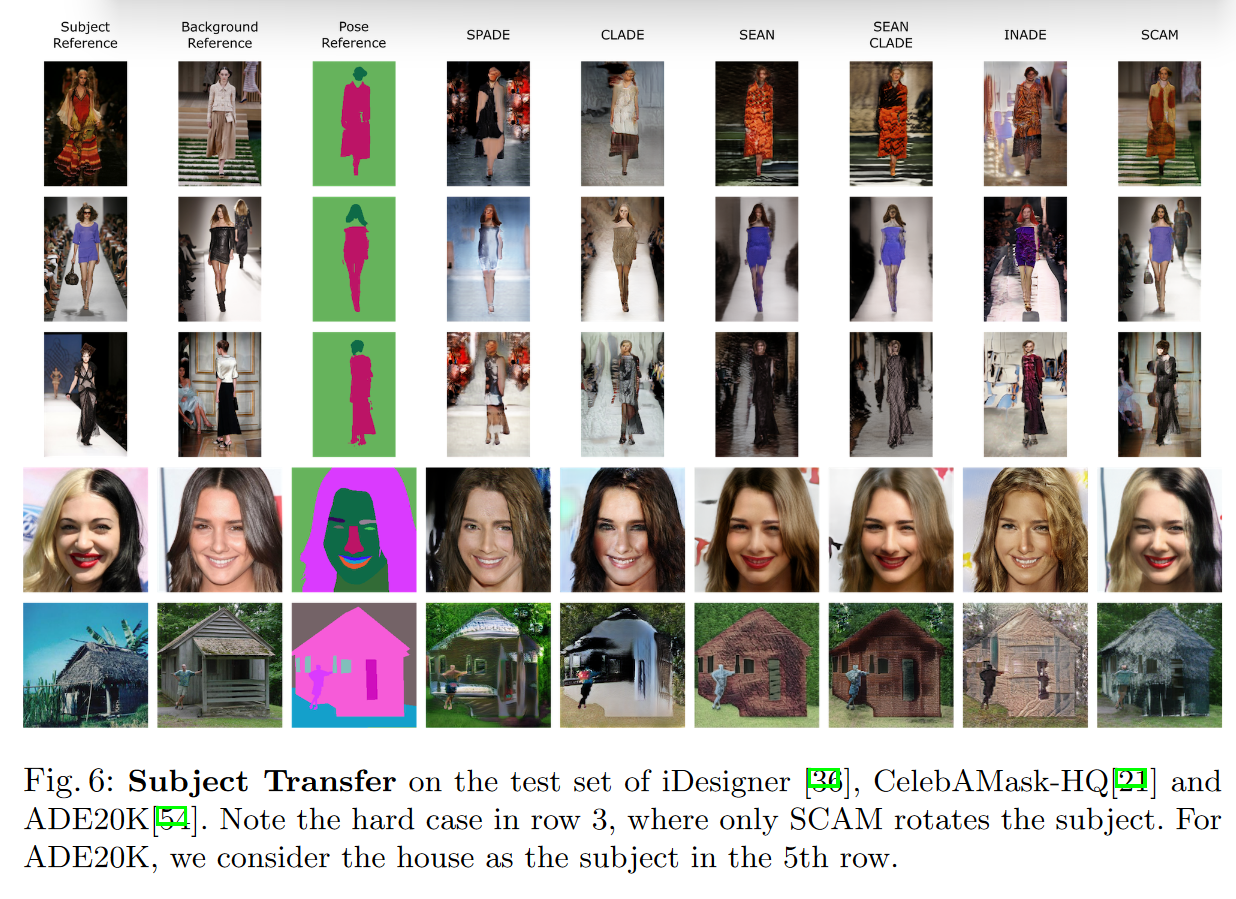

图 6:在 iDesigner 、CelebAMask-HQ 和 ADE20K的测试集上进行主题迁移。 请注意第 3 行中的案例,其中只有 SCAM 旋转了主题。 对于 ADE20K,我们将房子视为第 5 行的主题。

4.5 Qualitative results on subject transfer 主题转移的定性结果

图 6 显示了主题和背景图像以及姿势的分割掩码(前三列)。 然后我们展示了 SPADE 、CLADE 、SEAN 、SEAN-CLADE 、INADE 和 SCAM(最后六列)的主题转移。 前三行是来自 iDesigner 的样本,第四行来自 CelebAMask-HQ,最后一行来自 ADE20K。 总的来说,在所有方法中,SCAM 是成功保留主题转移所有组成部分的方法:主题外观、背景外观和姿势。虽然其他方法无法旋转主体,但 SCAM 确实成功了,即使生成的图像质量很低。总体而言,与其他方法相比,SCAM 中的对象具有更好的外观,例如衣服、鞋子或脸部的细节。

CelebAMask-HQ 上的主题转移。

第四行显示 SCAM 在传输的图像中恢复了更多细节,例如皮肤颜色或面部表情。 值得注意的是,SCAM 确实捕获了头发的双色分离,而 SEAN、SEAN-CLADE 和 INADE 显示的是平均头发颜色。

ADE20K 上的主题转移。

在第五行,我们将房子视为我们要转移的主题。 我们可以看到 SCAM 确实转移了主题的小屋外观,而竞争方法则未能做到这一点。 我们还观察到大多数方法在人生成方面都有困难,只有 SCAM 生成与背景参考一致的人。

5. Conclusion

我们介绍了执行语义编辑的 SCAM,特别是图像中的主题转移。 SCAM 的架构贡献是:首先,语义交叉注意 (SCA) 机制在特征和一组隐变量之间进行注意,限制它们只关注语义有意义的区域; 其次,语义注意转换器编码器(SAT)基于语义注意掩码检索信息; 第三,语义交叉注意调制生成器(SCAM)执行基于语义的生成。 SCAM 通过利用每个语义区域的多个隐变量并在编码和解码阶段提供更精细的潜在向量编码来设置最新的技术水平。

自己比较完整看的第一篇论文 可能有很多不对的地方,大家可以指正。